A Air Canada teve que pagar compensação a um neto enlutado. Isto porque ele alegou que comprou, por indução da plataforma, passagens aéreas pelo preço total através de um chatbot mal informado.

O Tribunal de Resolução Civil (CRT) da Colúmbia Britânica considerou a companhia aérea responsável pelo mau aconselhamento. Assim, um chatbot no site da empresa foi o responsável pelo dano, o que significou que um passageiro não pôde reivindicar uma tarifa de luto.

Em um argumento que surpreendeu um juiz de pequenas causas na Colúmbia Britânica, a companhia aérea tentou se distanciar do mau conselho de seu próprio chatbot, alegando que a ferramenta online era “uma entidade legal separada responsável por suas próprias ações.”

“Esta é uma apresentação notável”, escreveu Christopher Rivers, membro do Tribunal de Resolução Civil (CRT).

“Embora um chatbot tenha um componente interativo, ele ainda é apenas uma parte do site da Air Canada. Deveria ser óbvio para a Air Canada que é responsável por todas as informações em seu site. Não faz diferença se as informações vêm de uma página estática ou de um chatbot.”

‘Palavras enganosas’

Em uma decisão divulgada esta semana, Rivers ordenou que a Air Canada pagasse a Jake Moffatt $ 812 para cobrir a diferença entre as tarifas de luto da companhia aérea e os $ 1.630,36 que pagaram por passagens de preço total de ida e volta para Toronto compradas depois que sua avó faleceu.

Chatbot de suporte

A avó de Moffatt morreu no Dia da Lembrança de 2022. Moffatt visitou o site da Air Canada no mesmo dia.

Jake Moffatt afirmou ter comprado passagens de preço total para Toronto e de volta com base no conselho de um chatbot de que poderiam fazer retroativamente uma reivindicação de luto. “Enquanto usavam o site da Air Canada, eles interagiram com um chatbot de suporte”, diz a decisão.

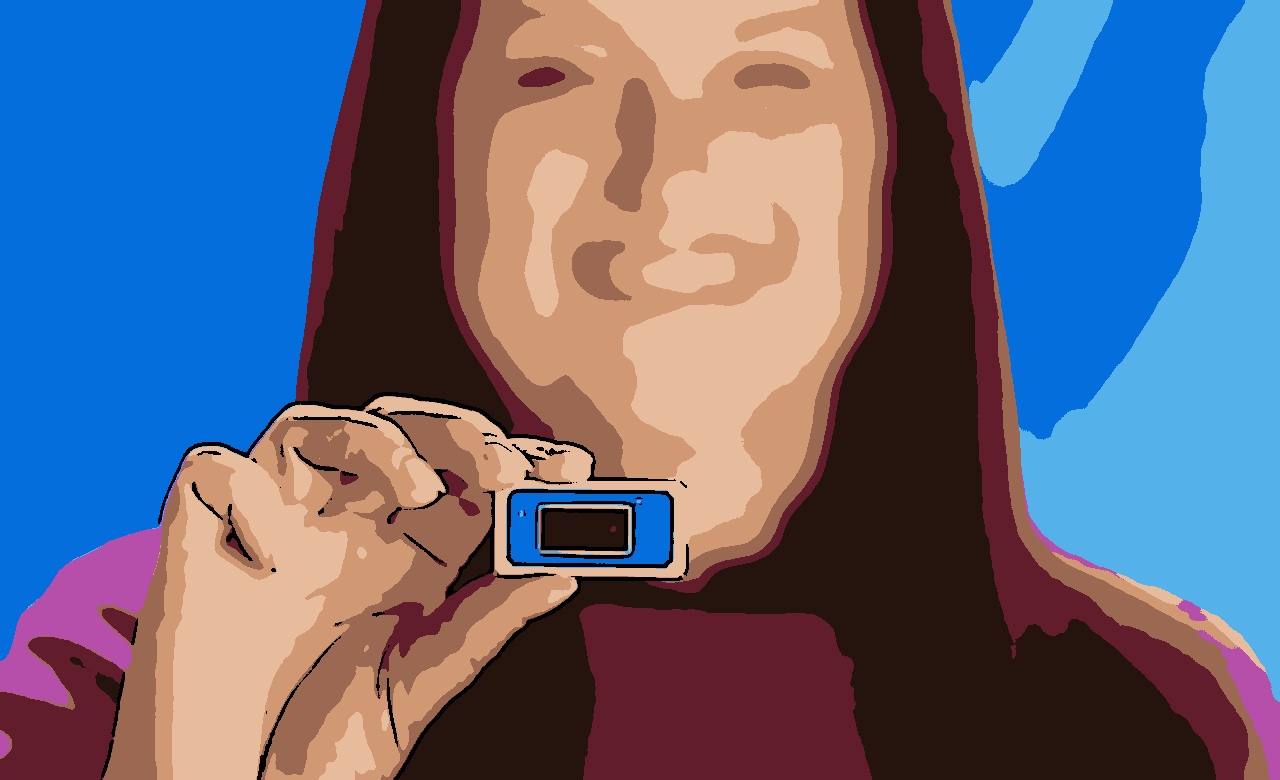

Moffatt forneceu ao CRT uma captura de tela das palavras do chatbot:

“Se você precisar viajar imediatamente ou já tiver viajado e gostaria de enviar seu bilhete para uma tarifa reduzida de luto, por favor, faça-o dentro de 90 dias a partir da data em que seu bilhete foi emitido, preenchendo nosso formulário de Solicitação de Reembolso de Bilhetes”.

Com base nessa garantia, Moffatt afirmou ter reservado passagens de preço total de ida e volta para Toronto.

Mas quando eles entraram em contato com a Air Canada para recuperar seu dinheiro, foi-lhes dito que as tarifas de luto não se aplicam a viagens concluídas – algo explicado em outra parte de seu site.

Moffatt enviou uma cópia da captura de tela para a Air Canada – apontando o conselho do chatbot em contrário.

“Um representante da Air Canada respondeu e admitiu que o chatbot havia fornecido ‘palavras enganosas'”, escreveu Rivers.

“O representante destacou o link do chatbot para a página da web de viagens de luto e disse que a Air Canada havia observado o problema para poder atualizar o chatbot.”

Aparentemente, Moffatt achou isso pouco reconfortante – e optou por processar.

Chatbot enganoso: ‘cuidado razoável’ não existiu para garantir precisão

De acordo com a decisão, a Air Canada argumentou que não pode ser responsável pelas informações de um de seus “agentes, servos ou representantes – incluindo um chatbot“.

Mas Rivers observou que a companhia aérea “não explica por que acredita que esse é o caso”.

“Concluo que a Air Canada não tomou cuidado razoável para garantir que seu chatbot fosse preciso”, concluiu Rivers.

A Air Canada argumentou que Moffatt poderia ter encontrado as informações corretas sobre as tarifas de luto em outra parte do site da companhia aérea.

Mas, como Rivers apontou, “isso não explica por que a página da web intitulada ‘Viagens de Luto’ era inherentemente mais confiável do que seu chatbot.”

“Não há motivo para que o Sr. Moffatt deva saber que uma seção do site da Air Canada é precisa e outra não”, escreveu Rivers.

Uma pesquisa do Instituto de Informações Jurídicas do Canadá – que mantém um banco de dados de decisões jurídicas canadenses – mostra uma escassez de casos com conselhos ruins de chatbots; o de Moffatt parece ser o primeiro.